- 作者: 魚屋

- 出版社/メーカー: 日本実業出版社

- 発売日: 2016/01/28

- メディア: 単行本

- この商品を含むブログを見る

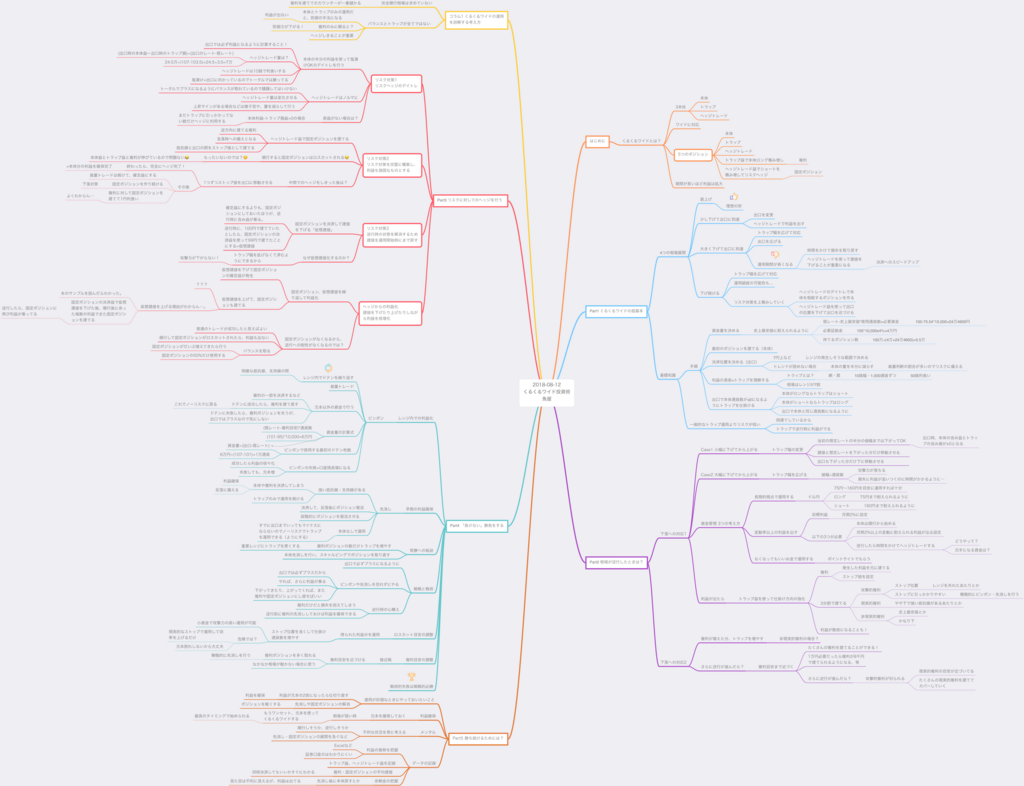

昔から少しやっている投資法である、くるくるワイドだけれど、理解しては忘れる、を繰り返していたので、マインドマップにまとめながら本を再読した。

くるくるワイドは放置系ではない

基本は、本体と、その同量のトラップを仕掛けておくのであるけれど、これだけで放置しておけばいいというものではない。デイトレのヘッジトレードで得た利益で、固定ポジションを作っていく必要がある。

本体をロングとした場合、100円で7万ドル持っていたとして、出口が107円の場合、(107-100)x7=49万円が本体の利益。 トラップはショートになって、10銭刻みでのトラリピとなり、出口の107円が損切りラインとなり、出口に着いたら24.5万円の損。 100円から107円にたどり着くまでにトラップは500円ずつヒットするので、利益は107円までにヒットした回数x500円。

裁量トレードを行わない場合ですんなり上がった場合は、

49万-24.5万+トラップ益=24.5万+トラップ益

となって、儲かりそうではあるが、すんなりと順行でいくことは滅多にない。

そこで、24.5万円の予定利益分を使って、ヘッジトレードを行う。

ヘッジトレードが肝

ヘッジトレードは、出口を損切りラインにした10銭幅のデイトレで、玉数を多く建てることができる。 話を簡単にするために、100円のときに3.5万ドルでヘッジトレードをしたとする。

ヘッジトレードが成功した場合

3.5万x0.1=3,500円の儲けとなる。

ヘッジトレードが失敗した場合

(107-100)x3.5=24.5万の損切りとなるが、本体ロングとトラップの利益は24.5万+トラップ益なので、

24.5万+トラップ益-24.5万=トラップ益

となり、もしヘッジトレードが塩漬けになっても出口でマイナスにはならない。

なので、出口でも損はしないという心理的安全を元に、積極的にヘッジトレードを仕掛けていくべき。成功すれば、建て玉数が多いだけに、利益も大きい。何度でもやってよい。個人的には抵抗線の手前で仕掛けたら成功しやすいんじゃないかなと思った。

複利で利益倍増する

くるくるワイドが放置系でないところは、ヘッジトレードだけではなく、複利もである。

複利は、トラップで得た利益を3分割して本体と同じ向きで再投資するものだ。

1日1,500円のトラップ益が発生したとすると、それぞれに500円ずつ割り振っていく。

ドル円が100円で、攻撃的複利のストップロスが95円、現実的複利のストップロスが90円、非現実的複利のストップロスが75円として、トラップ益がそれぞれ5万円ずつ貯まっているとすると

| 攻撃的複利 | 現実的複利 | 非現実的複利 | |

|---|---|---|---|

| ストップロス | 95 | 90 | 75 |

| 1枚あたりの必要トラップ益 | 5,000円 | 10,000円 | 25,000円 |

| 複利ポジション数 | 10 | 5 | 2 |

となり、複利は合計1.7万ドルとなり、もしこれが出口までたどり着いたら(107-100)x1.7=11.9万円の上乗せ利益となる。

実際は値動きは荒いし、攻撃的複利がストップロスにひっかかることもあるのだけれど、

という点がある。例えば、ドル円が94円になってしまって攻撃的複利が切られたとする。5万円の損ではあるけれど、この損はあくまでトラップ益であり、元本ではない。そして、94円になるまでにトラップ益が8万円貯まっていたとすると現実的複利、非現実的複利に4万ずつ割り振ったとして…

| 攻撃的複利 | 現実的複利 | 非現実的複利 | |

|---|---|---|---|

| ストップロス | 95 | 90 | 75 |

| 1枚あたりの必要トラップ益 | ---- | 4,000円 | 19,000円 |

| 複利ポジション数 | ---- | 15 | 4 |

となり、複利ポジションは19になっている。また、現実的複利にたどり着く前に反転する可能性は高い(あくまで、そういう支持線の下辺りにストップを置くから)。値下がりは、複利ポジションを増やすチャンスでもある。ナンピンっぽいけれど、あくまでトラップ益の範囲でやる。

私が思う本命、「固定ポジション」

くるくるワイドの本命は、この「固定ポジション」だと思う。これがリスクを抑えるための要になる。固定ポジションとは、ヘッジトレードで得た利益で建てる本体との逆のポジションのことで、つまり両建てである。個人的には、複利も大事だけれど、トラップ益で固定ポジション建ててもいいと思う。

本体に対しての両建て=固定ポジションなのだが、なぜこれを建てる必要があるのかというと「逆行対策」のためである。 くるくるワイドの弱点は、逆行。くるくるワイドをよく理解せずに放置系だと思って始めた頃は、本体ロングした途端に逆行して即マイナスになって半年くらい苦しんだのだけれど、固定ポジション(ショート)をしておいたら、下がってもダメージが少ない、または、なくなる(完全にヘッジし終わっていたら)。

そして、下がって支持線の辺りで固定ポジションを決済したら、ショートの利益が得られる。

固定ポジションの位置

固定ポジションは、抵抗線の上と出口の中間くらいをストップロスとして建てていく。あくまでヘッジトレードの利益も、出口までの道具として使う。 ヘッジトレードで1回につき3,500円の利益、103.5円に固定ポジションをつけるとして、35,000円のヘッジトレード益があったとする。

| 固定ポジション | |

|---|---|

| 固定ポジションのストップロス | 103.5 |

| 1枚あたりの必要ヘッジ利益 | 3,500円 |

| 固定ポジション数 | 10 |

この状態で100円から99円に下がったとしたら、本体ロングが70なので、-7万円になるのだけれど、固定ポジションは+1万円になり、トータルで-6万円となり、傷が浅く済む。

こんな感じで固定ポジション数を70になるまで積み増すと、100円が99円になってもプラスマイナス0となる。やったね! しかし、103.5円を迎えると、固定ポジションはロスカットされる…。24.5万円マイナスになるが、これはヘッジトレードで得た利益のため、元本には影響しない。そして、本体ロングがプラス24.5万円になっているので、運用上はプラスになっていて喜ばしい、ということだ。

固定ポジションをヘッジしきったら?

固定ポジションを70までヘッジしきったら、もう下落はノーリスクとなる。むしろ、下落=トラップトレードの成功なので利益が出る。しかし、ヘッジトレードがストップロスにひっかかるとやはり勿体無い。そこで今度はヘッジトレード益で固定ポジションの損切りラインを107円に変更していく。これの意味は一体なんなのか?

これは、本体ロングで予定していた利益(49万)を100%確保したという状態になる。これで完全にノーリスク。利益を確保した上でノーリスク。あとは出口にくるまでトラップトレードで得た利益を元に複利を建てていき、複利に対して固定ポジションを追加していく等をすればよい。

くるくるワイドのリスクコントロールの上で重要なのが、固定ポジションである。両建て強い!

先消し、ピンポンなどの裁量トレード

この辺りは運用が面倒な人はやらなくてもいいだろうけれど、利益率が大きく変わるのでちゃんと理解しておいたほうがいい。 正直、ヘッジトレードをやる意味と、固定ポジションと複利を理解できたら、リスクを抑えて出口でプラスにすることは可能であると思う。 しかし、それだけだと利益が乗りにくい。

為替はトレンドが順行であったとしても、必ずどこかに抵抗線がある。抵抗線を迎えると、越えられずに反落することが多い。反落する可能性が高いんだったら、複利を抵抗線付近で決済して、反落後に複利を建て直すというのが先消しである。

先消しして、反落しなかったら?

もし反落せずに抵抗線を越えたとしても、利益確定はできている。

先消しして、反落したら?

105円に抵抗線があるとして、その付近で先消し(決済)して、予想通り104円まで反落したとしたら、104円で買い直したら1円分利益を得られた上に、複利のチャンスが得られる。

本にも書いてあったけれど、先消しで損をするわけではないから、積極的に先消ししていくほうがよさそう。先消しを躊躇していたら下がってきて攻撃的複利がロスカットされてしまう…とかになると勿体無い。

ピンポン

ピンポンも、先消しで得られた利益を使ってレンジ相場でハイレバで勝負するというやつで、うまくいけば大きな利益が得られる。ただし、やや難易度が高めに感じる。失敗したとしても、複利の利益が飛んだだけだから問題ないという考えということだ。

固定ポジションも決済対象

固定ポジションに利益が乗っている状態で、トラップのレンジが外れそうだったら、固定ポジションを決済して仮想建値を下げる。仮想建値を下げて、出口も下げる。なぜ固定ポジションを決済してまで仮想建値を下げるのか?というと、トラップ値幅を拡げないため。トラップ値幅が拡がると、攻撃力が落ちるから。

具体例でいうと、100円スタートで107円出口だったけれど、逆行してしまい、96.5〜103.5円のトラップにしていたのに(トラップ値幅10銭刻み)、さらに96円まで落ちてトラップのレンジから外れたとする。こうなると、大幅逆行のときのルールに則って、100円を中心に線対称にレンジとゴールを広げることになる。たとえば、95〜105円とか。今までは103.5-96.5=7円だったので、7÷70=0.1で10銭刻みでよかったのだが、10÷70=0.14となり、14銭刻みになる。こうなると攻撃力が下がる…。

そこで、固定ポジションを決済して、その利益で仮想建値を95円始まり扱いにして、95〜102円としてしまえば、7円なので、トラップトレードの値幅は10銭刻みとなり、攻撃力は落ちない!ということだと私は理解した。

固定ポジションを持ってヘッジしきることも大事だけれど、攻撃力を保つことも大事で、要はバランスだと魚屋さんは書いていた。

まとめ

出口では必ずプラスになるように調整して、まずリスクヘッジしていこうというのが、魚屋さんの理論なのだと理解した。効率の良し悪しよりも生き残りやすい方針だと思う。最後に、のところで、退場してしまうということは、リスク管理できてないということとあった。本体建てた直後に天変地異があったら仕方ないけれど、そうでなければ、くるくるワイドはいい戦略だなぁと個人的に思う。今までの運用で勘違いしていたところがあったので、もっと積極的に固定ポジションを取っていこうと思った。

![エキスパートのためのMySQL[運用+管理]トラブルシューティングガイド エキスパートのためのMySQL[運用+管理]トラブルシューティングガイド](https://images-fe.ssl-images-amazon.com/images/I/41oqE-9dM2L._SL160_.jpg)